סוכן Ai – לא תוכנה. בן אדם.

"שלום, אני הסוכן שלך. מה אוכל לעשות בשבילך היום?"

כשאני רואה את השורה הזו על המסך, משהו בתוכי מתנגד. לא להודעה עצמה, אלא למה שהיא מייצגת – האמת שכולנו מנסים להתעלם ממנה. האינטליגנציה המלאכותית כבר לא רק כלי. היא הפכה למשהו אחר לגמרי.

(רמז – זו לא תוכנה. זה בן אדם)

השינוי שקרה מתחת לאף שלנו

עד לא מזמן, כשדיברנו על AI, התכוונו בעצם לתוכנה מתוחכמת. אלגוריתם (ליתר דיוק – מודל, מה ההבדל? קראו פה) שיכול לענות על שאלות, להשלים משפטים, אולי לכתוב טקסט. בסך הכל, כלי חכם במיוחד.

אבל משהו השתנה בשנתיים האחרונות. ההבדל כל כך דרמטי שאפילו המילים שלנו לא מתאימות יותר. אנחנו עדיין קוראים להם "מודלי שפה" או "צ'אטבוטים", אבל המציאות היא אחרת לגמרי.

הם כבר לא סתם עונים. הם חושבים, מתכננים ומבצעים עבודה אמיתית עבורנו, ובשמנו.

מה קורה כשמכונה מתחילה לחשוב?

בואו נעצור לרגע ונחשוב על מה שקורה כשאתם שואלים את ChatGPT: "האם עלי לקחת מטריה היום?"

במבט ראשון זה נראה פשוט – השאלה נשלחת לשרת, אלגוריתם מעבד, תשובה חוזרת. כמו שאילתה בגוגל.

אבל זה לא מה שקורה באמת.

במקום לחפש תשובה קיימה, המערכת מתחילה לחשוב:

- "אני צריך מידע על מזג האוויר כדי לענות על השאלה הזו"

- "איך אני משיג את המידע הזה?"

- "יש לי גישה ל-API של מזג אוויר?"

- "אם כן, איזה אזור גיאוגרפי מעניין אותי?"

- "איך אני מנסח את התשובה בצורה מועילה?"

וזה רק ההתחלה. כי אז הוא באמת פונה למקור המידע, מקבל את הנתונים, מנתח אותם ומחליט איך לענות.

זה לא רק הבנת טקסט. זה לא רק ניסוח תשובה. זה תהליך חשיבה.

למה זה שונה מכל דבר שהכרנו לפני כן?

כדי להבין מה זה סוכן, לפעמים הכי פשוט להתחיל ממה זה לא סוכן – סוכן הוא לא אוטומציה מסורתית.

הנה דוגמא שתסביר הכל:

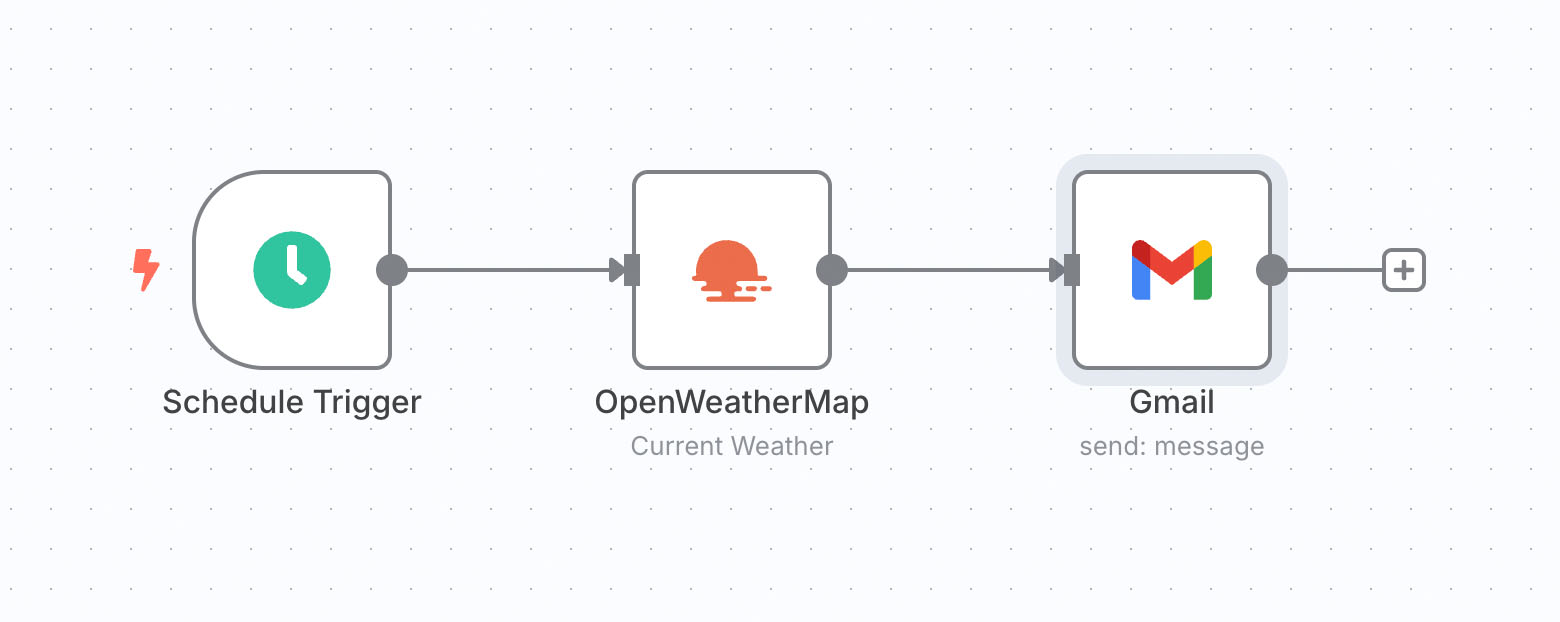

אוטומציה מסורתית

- כל בוקר ב-8:00

- בדוק מזג אוויר

- שלח אימייל עם התחזית

- סיום

זה מתרחש בדיוק באותו אופן, בכל פעם. אין חשיבה, אין התאמה, אין גמישות.

זה מה שנקרא ״לוגיקה עסקית״ – Business Logic. עבודה קלאסית של מתכנתים, שמתארים במילים (קוד, שפת פיתוח) את אופן הפעולה המדויק של התוכנה, כתגובה למצבים משתנים. בעוד שתרשים הזרימה של הלוגיקה העסקי או אלגוריתם, יכול להיות מורכב מאוד, עם אלפי הסתעפויות – המבנה כולו ידוע מראש, וניתן לחזות את אופן התגובה לכל מצב נתון.

סוכן AI

מצד שני, סוכן Ai יכול להיות פשוט מאוד, אבל תהליך הפעולה שלו נראה משהו כזה:

- משתמש שואל: "האם כדאי שאקח מטריה היום?"

- הסוכן חושב: "מה אני צריך בשביל לעזור למשתמש? אני צריך מידע על מזג האוויר! האם יש לי יכולת להשיג את המידע? כן!"

- הסוכן פועל: קורא ל-API של מזג אוויר

- הסוכן מנתח: "יש 70% סיכוי לגשם אחר הצהריים"

- הסוכן מנסח תשובה: "כדאי לקחת מטריה, אבל רק אם יוצאים אחר הצהריים"

רואים את ההבדל? יש כאן הגיון, התאמה והחלטה דינמית.

תרשים הזרימה לא היה ידוע מראש, הוא נבנה במהלך הדרך, בכל שלב הסוכן שואל את עצמו – ״מה אני צריך לעשות עכשיו כדי לעמוד במשימה?״, והוא מחליט בעצמו מה יהיה השלב הבא.

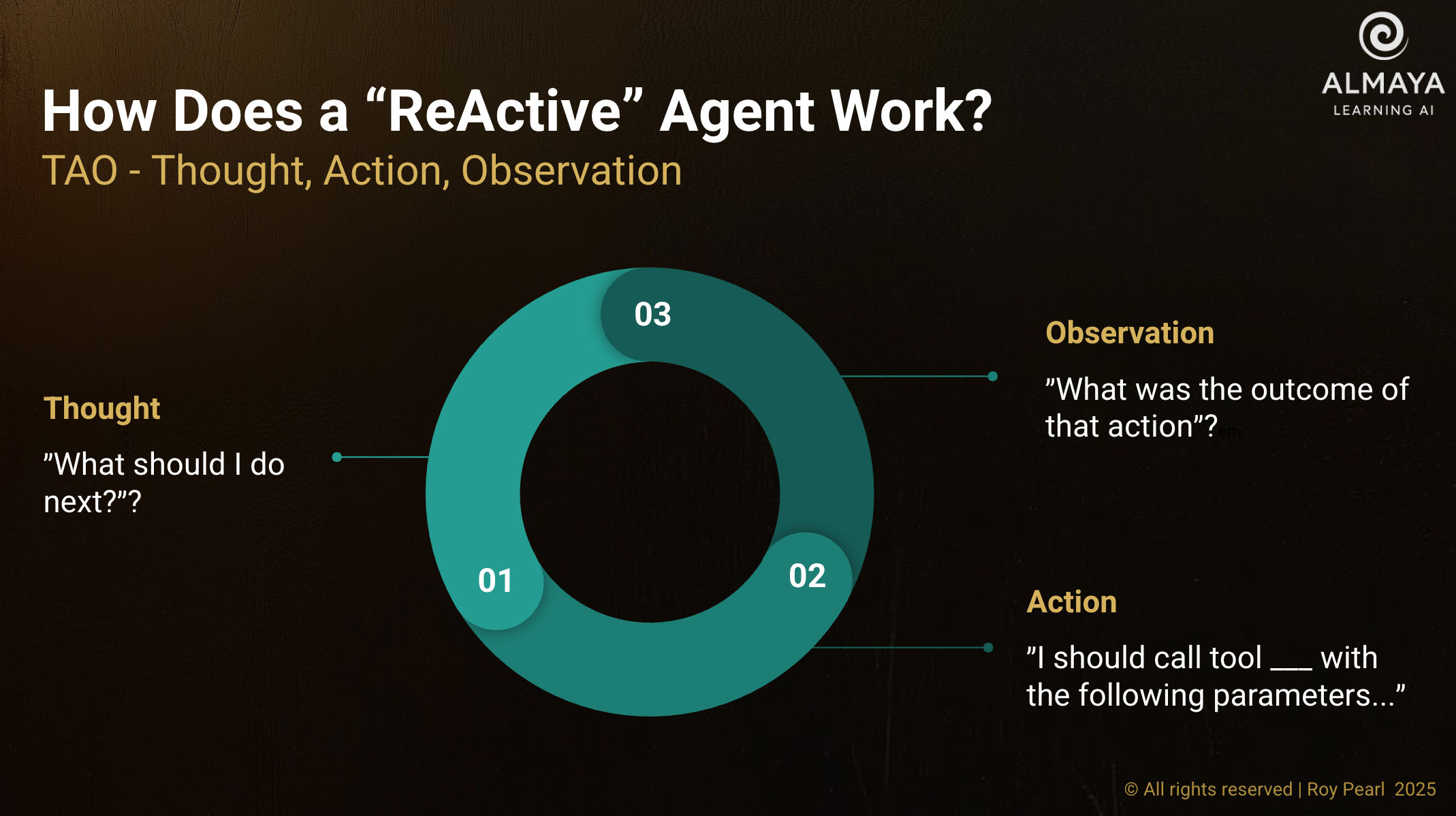

זה נקרא ״הסקת מסקנות״ או Reasoning, והלולאה שתוארה לעיל נקראת Reasoning Loop (או TAO Loop – קיצור של Thought, Action, Observation)

אנחנו נחזור לכך בהמשך.

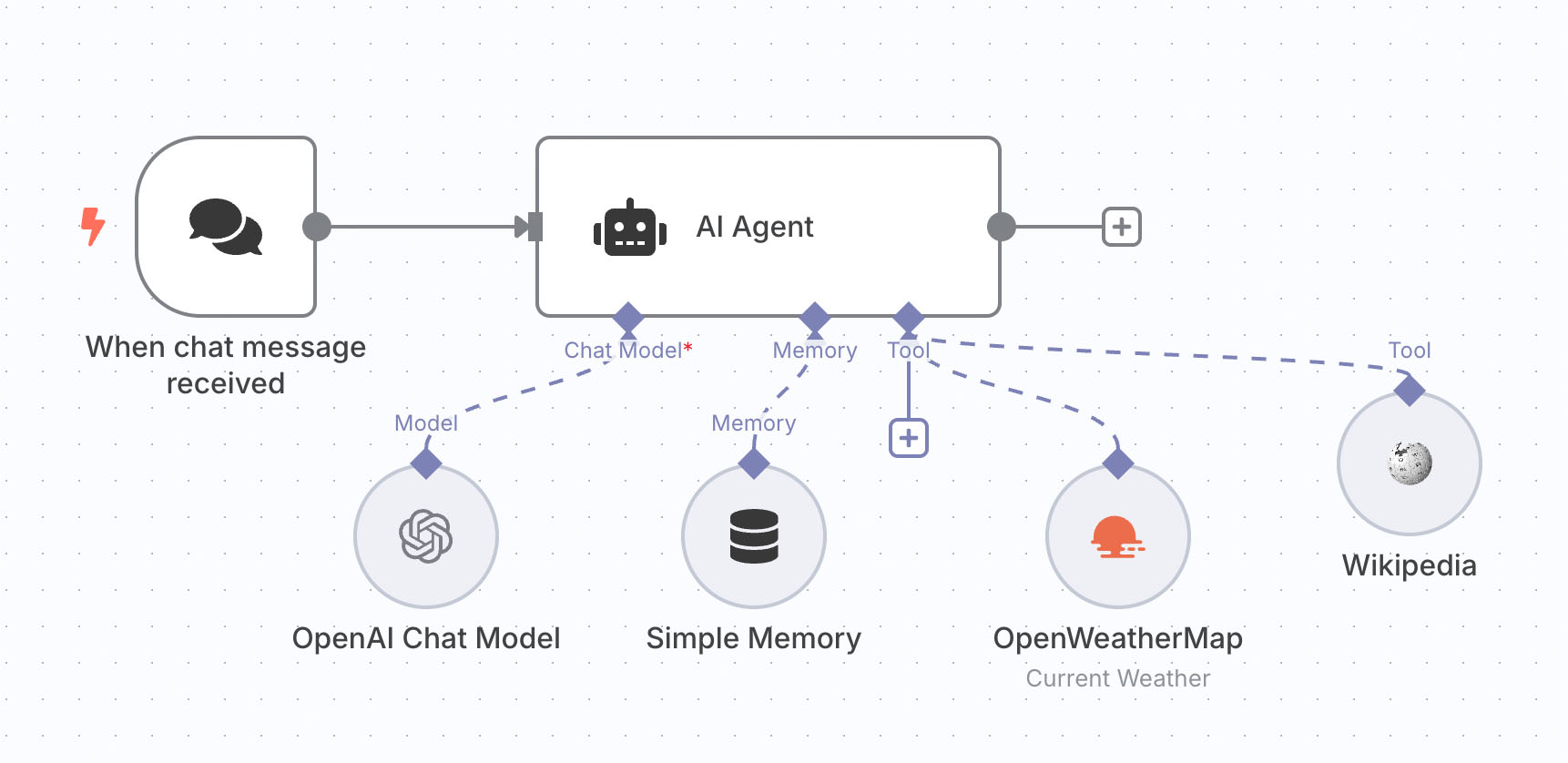

שלושת המרכיבים שהופכים סוכן ל… סוכן

בואו נרים את מכסה המנוח ונפרק את הקסם הזה למרכיבים.

כמו שלכל בן אדם יש מוח, זיכרון ויכולת לפעול בעולם – כך גם לסוכן AI יש שלושה מרכיבים בסיסיים:

1. המוח – מנוע החשיבה

זה מודל השפה הגדול שמניע את הסוכן. אבל כאן חשוב להבין משהו: הוא לא סתם מעבד טקסט. הוא מנמק, מתכנן ומחליט.

בדיוק כמו שאתם לא סתם זוכרים מילים כשמישהו שואל אתכם שאלה – אתם חושבים על התשובה.

לבני אדם יש באופן כללי 2 אופני חשיבה:

- חשיבה אינטואיטיבית – פעילות קוגניטיבית המתקיימת במוח אנושי עוד לפני הלידה. חשיבה זו מתאפיינת בדימויים חושיים ולא-חושיים שלא ניתן בהכרח לבטא במילים.

- חשיבה מילולית – זה תהליך ״הדיבור הפנימי״, האדם חושב דרך שיחה עם עצמו, לפעמים באופן סדור ולפעמים לא, אבל ניתן לומר שהיחידות האטומיות בתמונת המציאות דרך החשיבה המילולית היא האותיות. המציאות מורכבת מאותיות.

בעוד שהחשיבה האינטואיטיבית היא עדיין דבר המייחד את בני האדם, חשיבה מילולית מתבצעת היום ע״י מודלי שפה.

אם החשיבה המילולית היא דיבור פנימי – הרי שמודל השפה יכול לייצר טקסט שמכוון כלפי עצמו, פנימה, וזה הופך את הטקסט לא לדיבור – אלא למחשבה. ״מה אני צריך לעשות בשלב הבא?״ הוא טקסט המייצג חשיבה.

2. הזיכרון – ההקשר המצטבר

כמו שראינו בפוסט קודם בנושא – מודל שפה היא פונקציה מתמטית ותו לא. וככזאת – אין לה זיכרון.

מודל שפה מתייחס לכל פניה (Prompt) כייחודית. אין לו זיכרון של היסטוריית שיחה, של פרטי המשתמש ושל שיחות קודמות.

״מה? אבל ChatGPT מנהל איתנו שיחות ארוכות וקוהרנטיות, הוא יודע עלינו הכל!״

זה נכון, אבל מי ש״זוכר״ זה לא מודל השפה, אלא האפליקציה העוטפת את המודל. זה ההבדל בין מודל GPT, לבין אפליקציית Chat-GPT, שגם היא סוג-של סוכן!

בכל פניה שלכם למודל השפה במסגרת שיחה – האפליקציה שולחת למודל תקציר של כל היסטוריית השיחה שלכם, בצירוף פרטים חשובים אודותיכם, הרלוונטיים לפרומפט הנוכחי.

אבל רכיב הזיכרון, זה לא רק יכולת לזכור את השיחה הנוכחית. סוכן טוב זוכר אינטראקציות קודמות, לומד מהן, ויכול אפילו לגשת למידע חיצוני כמו מסמכים או מאגרי מידע. מה שנקרא RAG – או Retrieval Augmented Generation.

תחשבו על זה כמו הזיכרון האנושי – גם קצר טווח וגם ארוך טווח, שמשפיע על החלטות עתידיות.

3. הכלים – היכולת לפעול בעולם

וכאן מגיע החלק המרתק ביותר. סוכן לא רק חושב ונזכר – הוא גם פועל.

כמו לבנאדם שפועל בעולם – יש לו הרבה מעבר למוח וזיכרון. יש לו ידיים ורגליים וחושים – דרכם הוא יכול לקבל מידע על הסביבה בה הוא חי, ואף להתבטא באופנים שונים.

כך גם סוכן – הוא יכול לשלוח אימיילים, לעדכן קלנדר, לחפש באינטרנט, לעבד מסמכים, לעדכן מאגרי מידע, ועוד אלפי פעולות אחרות.

כמו בן אדם שיכול לחשוב, לזכור, ולפעול בעולם הפיזי.

כלים של סוכן Ai יכולים להיות כאלה שמביאים מידע עדכני מהעולם, כגון – API של שירות מזג אויר, וגם כאלו שמשאירים Side Effects, ״פועלים״ במציאות – כגון שליחת מייל, הזמנת ארוחת ערב מ Wolt, או הפעלת המים החמים בבית החכם. כל כלי יכול להיות ממומש ע״י קריאת API ברשת, או ע״י קוד, אלגוריתם, המופעל כחלק מהאפליקציה של הסוכן.

תוך שימוש בשלושת החלקים הללו – הסוכן, כמו בן אדם, יכול להתבטא בשלושה אופנים: מחשבה, דיבור ומעשה:

- מחשבה – הפניית דיבור כלפי עצמו

- דיבור – הפניית דיבור כלפי המשתמש

- מעשה – הפניית הדיבור כלפי הסביבה – העולם

אז איך כל אלה עובדים יחד?

על מנת לפעול – סוכן ReAct (קיצור של Reasoning & Action) מממש לולאת משוב הנקראת בקיצור TAO – Thought, Action, Observation:

1. מחשבה – Thought

מודל השפה שבבסיס הסוכן, מקבל פניה מהמשתמש, לדוגמא ״אני נוסע לירושלים עכשיו, האם לקחת מטריה?״.

הפרומפט נשלח למודל השפה יחד עם פרטים נוספים כגון: הוראות הפעלה (״הקשר״ – הגדרת התפקיד של הסוכן עם פרטים נוספים שיעזרו לו למקד ולדייק את פעילותו. נקדיש לכך פוסט נפרד), היסטוריית השיחה (במקרה של סוכן שיחה), ופרטים אודות הכלים הזמינים לסוכן.

מודל השפה בשלב הזה מייצר מחשבה – ״מה הפעולה הבאה שעליי לעשות על מנת לעמוד במשימה?״.

כמחשבה, דיבור פנימי – הטקסט הזה מנותב למודל השפה עצמו, והוא מחזיר תשובה כמו ״אני רואה שיש לי כלי של בדיקת מזג האויר, אני צריך להפעיל אותו״.

2. פעולה – Action

לאחר שמודל השפה החזיר מחשבה של ״הפעלת כלי״ – מתבצעת פעולה. איך זה קורה? זה הקשר בין המוח לבין הגוף של הסוכן.

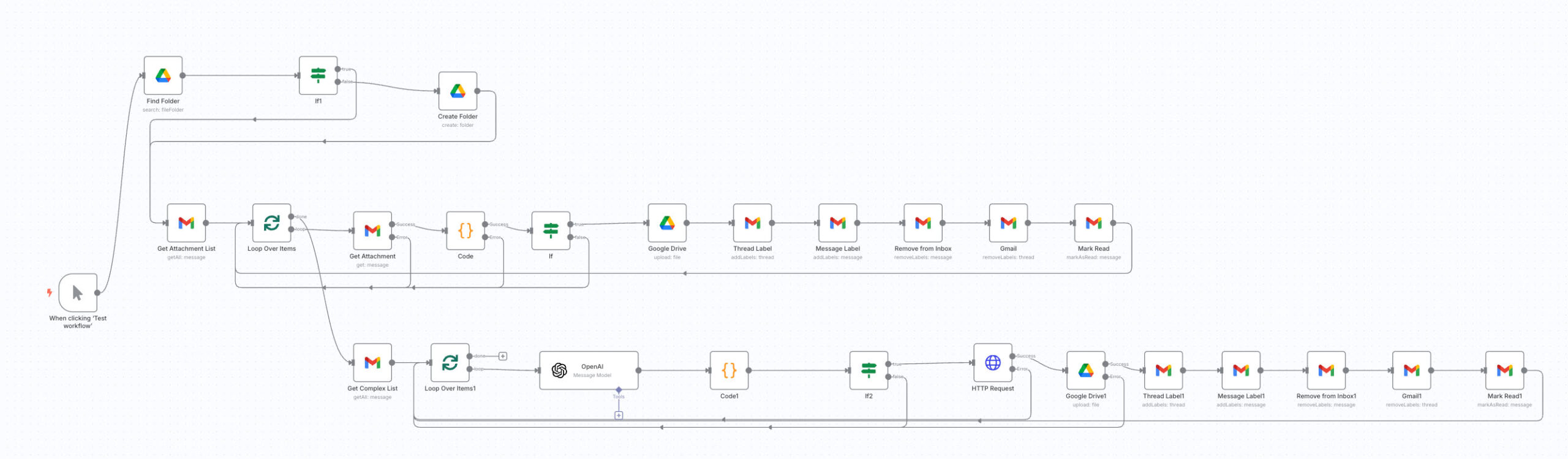

סוכן Ai הוא למעשה אפליקציה שבבסיסה עומד מודל שפה כמנוע קבלת החלטות, אבל עדיין – זו אפליקציה. עם קוד, אלגוריתמים, והרבה יכולות פעולה.

כאשר מודל השפה ״מחליט״ שיש לבצע פעולה כלשהי – הוא מבקש מ״אפליקציית המעטפת״ להפעיל את אחת הפונקציות הזמינות.

במקרה שלנו זה יהיה משהו כמו ״נא להפעיל את הכלי ״בדיקת מזג האויר״ עם הפרמטרים הבאים:

- שם עיר באנגלית – Jerusalem

- יחידות הטמפרטורה (Celsius)

- זמן התחזית (now).

האפליקציה תבצע קריאה לפונקציה המתאימה, עם הפרמטרים הנ״ל. על מנת לבצע את הפעולה – האפליקציה יכולה להתחבר ל Database, לפנות לשירות חיצוני דרך API, או להפעיל סוכן משנה המתמחה בכך. אין חשיבות לאופן המימוש על מנת להבין את העקרון.

3. תצפית – Observation

לאחר שהופעלה הפעולה המתאימה, תוצאת הפעולה הזאת (במקרה שלנו – תיאור מזג האויר) מוחזרת למודל השפה, כ״עוד מחשבה״, בתוספת המשימה המקורית, הוראות ההפעלה, היסטוריית השיחה, פירוט הכלים הזמינים וכל שאר הפרמטרים הדרושים לביצוע המשימה.

והמעגל חוזר לשלב המחשבה – ״אוקיי, אז אני יודע מה מזג האויר בירושלים… ומה אני צריך לעשות עכשיו?״

וכן הלאה וכן הלאה, על שהסוכן מסוכן להחזיר תשובה סופית ומספקת למשתמש.

אז למה נכון לחשוב על סוכני Ai כעל בני אדם?

השאלה הזו נשמעת פילוסופית, אבל היא מעשית לגמרי. הדרך שבה אנחנו חושבים על הסוכנים משפיעה על הדרך שבה אנחנו מתכננים, בונים ומשתמשים בהם.

כשחושבים על סוכן כעל תוכנה:

- נכתוב הוראות מדויקות ונצפה שהוא יבצע אותן בדיוק

- נתאכזב כשהוא "לא מבין" מה רצינו

- נחפש פתרונות טכניים לבעיות שהן למעשה בעיות תקשורת

כשחושבים על סוכן כעל עמית דיגיטלי:

- אנחנו נגייס אותו, לא ״נתכנת״ אותו

- נסביר לו את המטרה, לא רק את המשימה

- נתן לו הקשר ומידע רקע

- נמסור לו אחריות ונבקש שיחזיר דו"ח על מה שקרה

- נקבע איתו "גבולות" ו"כללי התנהגות"

- נבנה לו תהליך הכשרה, ובהדרגה נרכוש אליו אמון, וניתן לו אחריות

- עם הזמן – נסמוך עליו ש״יגדיל ראש״, וישחרר אותנו באמת מתחומי אחריות הולכים וגדלים

דוגמה מהחיים: סוכן לתכנון ריצות

דמיינו שאתם רצים קבועים ורוצים סוכן שיעזור לכם לתכנן את הריצות השבועיות.

אם תחשבו עליו כעל תוכנה, תנסו לתכנת אותו: "כל יום שלישי, בדוק מזג אוויר, אם שמשי – המלץ על מסלול A, אם גשום – על מסלול B"

אם תחשבו עליו כעל עמית, תגידו לו משהו כמו: "תפקידך הוא לעזור לי לתכנן ריצות. אני אוהב לרוץ 3-4 פעמים בשבוע, מסלולים של 5-10 ק"מ. חשוב לי לגוון, להימנע מגשם, ולקחת בחשבון את הלוח שלי. יש לך גישה ליומן שלי, לתחזיות מזג אוויר ולרשימת המסלולים המועדפים עלי. כל בוקר, בדוק אם מתוכנן לי לרוץ, ואם כן – שלח לי המלצה מותאמת אישית."

הסוכן עצמו יחליט מתי לבדוק את המזג האוויר, איך להתחשב ביומן, איזה מסלול מתאים למצב הרוח שלכם ולמטרות הריצה שלכם.

המעבר מכלי לשותף

זה המעבר המהותי שקורה כרגע בעולם הטכנולוגיה. AI כבר לא כלי שאנחנו משתמשים בו. הוא הופך להיות שותף שאנחנו עובדים איתו.

השותפות הזו דורשת מאיתנו לחשוב אחרת:

במקום לשאול "איך להפעיל את הכלי הזה?" נשאל "איך לעבוד עם השותף הזה?"

במקום לחפש "את הכפתור הנכון" נלמד לתקשר ביעילות

במקום לצפות לביצוע מדויק של הוראות נתן אחריות ונבקש תוצאות

מה זה אומר לגבי העתיד?

הסוכנים הולכים להיות חלק אינטגרלי מהחיים שלנו – בבית, בעבודה, ובכל תחום אפשרי. הם כבר עכשיו יכולים:

- לנהל את המיילים שלכם ולענות על פניות שגרתיות

- לתכנן לכם מסלולי נסיעה מותאמים אישית

- לחקור נושאים מורכבים ולהכין דו"חות מפורטים

- לנהל רשתות חברתיות ותוכן דיגיטלי

- לטפל בשירות לקוחות ולפתור בעיות טכניות

בארגונים מסוימים, אנו ב Almaya מגייסים ומכשירים סוכני Ai שפועלים כחלק אינטגרלי מצוות אנושי. יש להם אופי, סגנון תקשורת, ואפילו אותונומיה מסוימת.

הם משתתפים בדיונים, בשיחות Slack צוותיים, פועלים עצמאית, ונותנים ומבקשים משוב.

והכי חשוב – הם יכולים ללמוד מכל אינטראקציה ולהשתפר עם הזמן.

השורה התחתונה

כשהסוכן הבא יכתוב לכם "שלום, מה אני יכול לעשות בשבילך היום?", זכרו:

זה לא תוכנה שמחכה לקלט. זה לא בוט שמבצע פעולות מתוכנתות מראש.

זה ישות דיגיטלית שיכולה לחשוב, לזכור ולפעול.

והדרך היחידה להוציא מהם את המקסימום – זה להתייחס אליהם בדיוק כמו שהייתם מתייחסים לעמית אנושי מוכשר במיוחד.

כי בסופו של דבר, זה בדיוק מה שהם.